Informatiker der Universität in Maryland haben es geschafft, ihren Robotern das Kochen beizubringen: Das wäre an sich nicht besonders ungewöhnlich, wenn als Vorlagen nicht YouTube-Videos gedient hätten. Das Besondere dabei ist auch, dass Kochen einen erstaunlich komplexen Vorgang darstellt.

"Lehrer" YouTube

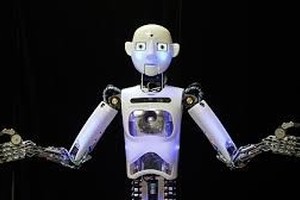

Die University of Maryland beschreibt auf ihrer Seite die aktuelle Forschung auf dem Gebiet der Robotik als Durchbruch: Ausgemalt wird ein Szenario, bei dem ein persönlicher Roboter einem täglich das Frühstück zubereitet. Dabei solle man sich auch vorstellen, so die Forscher, dass der Roboter das perfekte Omelett beherrscht und dabei keinerlei Hilfe gebraucht hat, weil er es online, genauer gesagt auf YouTube, gelernt hat.

Das ist aber eben den Informatikern gelungen: Sie haben es geschafft, dass die Maschinen eine ihnen gezeigte Szene "verstehen" und nicht bloß die dort zu sehenden Objekte erkennen. Besonders signifikant dabei ist, dass die Roboter eigenständig die effizienteste Kombination von Bewegungen, die sie beobachten, anwenden können.

Komplexer Vorgang

"Kochen ist in Sachen Manipulation komplex und zwar bei den Schritten, die man durchführen, und den Werkzeugen, die man verwenden muss", erläutert Yiannis Aloimonos, Chef vom University of Maryland Computer Lab. "Wenn man beispielsweise eine Gurke schneiden will, muss man ein Messer nehmen, es positionieren, den Schnitt durchführen und das Resultat beobachten, um sicherzustellen, dass man es richtig gemacht hat.

Für einfache Aufgaben wurde "Convolutional Neural Networks" (CNNs) eingesetzt, diese erlernen Programmiergerüste basierend auf biologischen Modellen, um die visuellen Daten zu verarbeiten. Ein CNN war die Klassifizierung von Handgriffen bzw. den entsprechenden Bewegungen, ein anderes diente der Objekterkennung.

Diese einzelnen vom Roboter gesehenen Aktionen wurden laut den Forschern so zusammengefügt, wie man in der Sprache Wörter zu Sätzen kombiniert. Die Erkennungsquoten waren verhältnismäßig hoch: 79 Prozent aller Objekte wurden erkannt, 91 Prozent der Griffbewegungen und bei Aktionsvorhersagen waren es 83%.

Matthew Wright 301-405-9267

Tom Ventsias 301-405-5933

http://winfuture.de/news,85628.html